TikTok es la app de las modas. Cada semana (o cada día) surgen nuevas tendencias a las que se apuntan miles y miles de usuarios de la plataforma, como una que nos mete en una película de Wes Anderson, otra sobre cosas con “bajas vibraciones” u otra que (filtro mediante) nos rejuvenece y nos muestra a nuestro yo adolescente.

Y, por lo “visto”, los creadores de inteligencias artificiales están muy al corriente de estas modas. ¿Qué por qué, preguntas? Porque gracias a estas modas, los desarrolladores pueden “entrenar” a sus IA a partir de las expresiones y movimientos de las personas que protagonizan sus vídeos.

En el caso que te traemos hoy, la web de noticias Vox (no confundir con el partido político español) ha analizado en un reciente vídeo cómo los desarrolladores de una IA se sirvieron de cientos de vídeos de TikTok en los que los usuarios bailan o realizan el popular Mannequin Challenge (una tendencia que fue muy famosa hace varios años), para que la inteligencia artificial aprendiera a “ver”. Te explicamos cómo.

¿Cómo se entrena a una IA para que pueda ver?

A la hora de entrenar una inteligencia artificial, estas necesitan asimilar miles y miles de conjuntos de datos distintos. Dependiendo del tipo de modelo de lenguaje artificial, este requerirá el input de un tipo de conjunto de datos en concreto. Por ejemplo, las IA de texto como ChatGPT se alimentan de textos de todo tipo y las IA de imágenes se sirven de muchas imágenes diferentes.

Con los vídeos ocurre algo similar. Su entrenamiento requiere que se analicen decenas, cientos e incluso miles de vídeos con el fin de encontrar una serie de “puntos medios” que sirven a la IA para detectar patrones y hacer que capacidad de procesamiento “entienda” cada vez mejor los aspectos de esta, nuestra realidad. Pero no todo es tan fácil como parece.

Los vídeos son elementos en dos dimensiones que parten de una realidad en tres dimensiones. Mientras que los humanos somos capaces de interpretar esas dimensiones al ver un vídeo, una IA no tiene esa capacidad de base, y necesita partir de conceptos tan básicos como interpretar qué es (físicamente) un ser humano y entender el espacio en el que se encuentra.

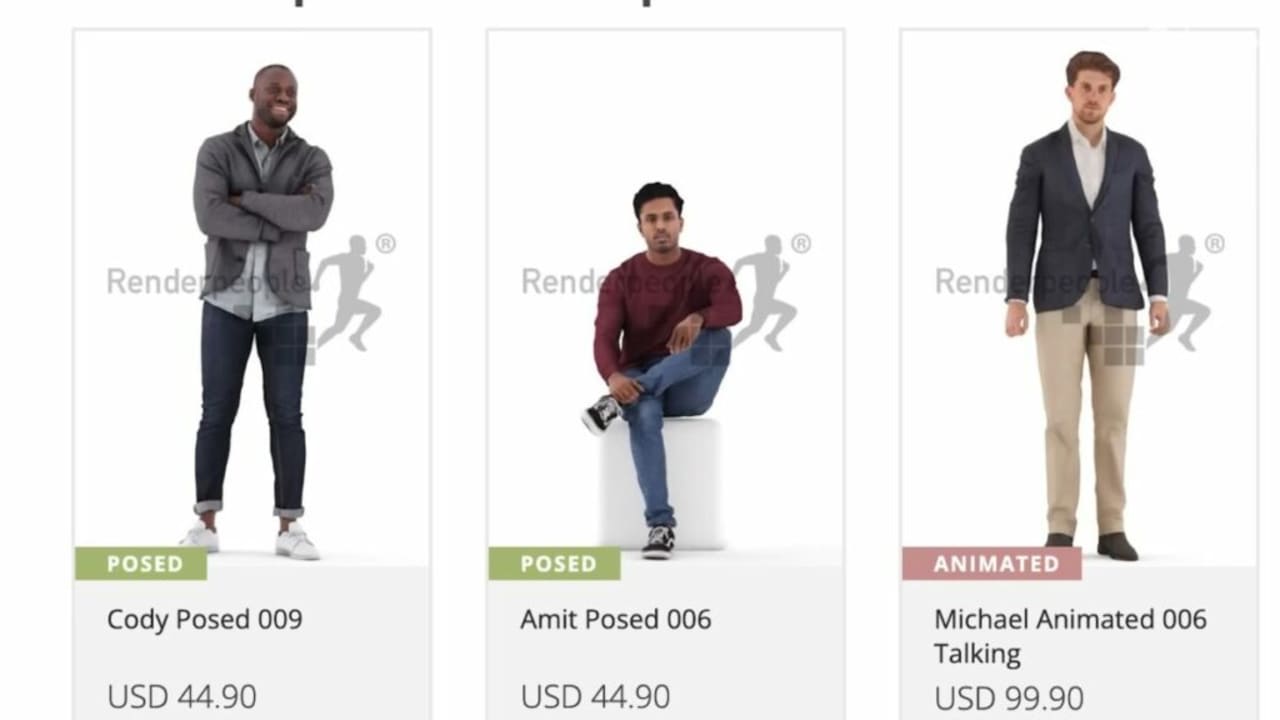

Yasamin Jafarian, una investigadora de la Universidad de Minnesota, comenzó a entrenar una IA partiendo de las imágenes, vídeos y escaneos 3D de una web llamada Renderpeople, proporcionando así datos de gran valor que sirven a la inteligencia artificial para interpretar el espacio en el que se sitúa una persona.

Pero, a pesar del gran valor de estos datos, la IA necesita entrenarse con diferentes contextos. En el caso de los vídeos, la IA requiere una gran variedad de fondos, diferentes movimientos de las personas que se encuentran en ellos, poses distintas, etc. Y ¿qué mejor sitio para encontrar todas estas cosas que en TikTok?

Hasta 600 vídeos de TikTok llegaron a utilizar los investigadores para entrenar a la IA. En estos vídeos, se puede ver a gente muy diversa con ropa, iluminación, fondos, movimientos y formas completamente diferentes, dando una inmensa variedad de conjunto de datos a la inteligencia artificial.

Pero para enseñar a la IA qué es la profundidad en un espacio tridimensional, los investigadores no solo utilizaron a gente en movimiento, sino que también se sirvieron de personas completamente estáticas. Y ¿recuerdas una tendencia de Internet en la que todo el mundo debía estar quieto? Exacto, también utilizaron vídeos del famoso Mannequin Challenge.

A partir de la friolera de 2.000 vídeos completamente diferentes de “gente congelada” haciendo el Mannequin Challenge, los desarrolladores de la IA crearon un gran conjunto de datos de vídeos con personas estáticas donde la cámara se mueve a su alrededor, dándole a la IA los datos necesarios para “triangular” sus posiciones y permitirle conocer el espacio tridimensional en el que se encuentran.

Con la capacidad de “ver” y conocer el espacio en el que se encuentran los elementos de una imagen, la IA puede comenzar a “adivinar” cómo sería un frame del vídeo si una persona se moviera varios centímetros, si saltara o si se tumbara en el suelo.

Obviamente, este es solo el comienzo y este tipo de IA todavía necesitan de un entrenamiento mucho más extenso, pero resulta llamativo lo útiles que pueden ser para el desarrollo y el avance de las IA elementos tan cotidianos y normales como los vídeos que subimos a TikTok, consideradas por muchos como la gran revolución de esta década.

Algunos de los enlaces añadidos en el artículo forman parte de campañas de afiliación y pueden representar beneficios para Softonic.