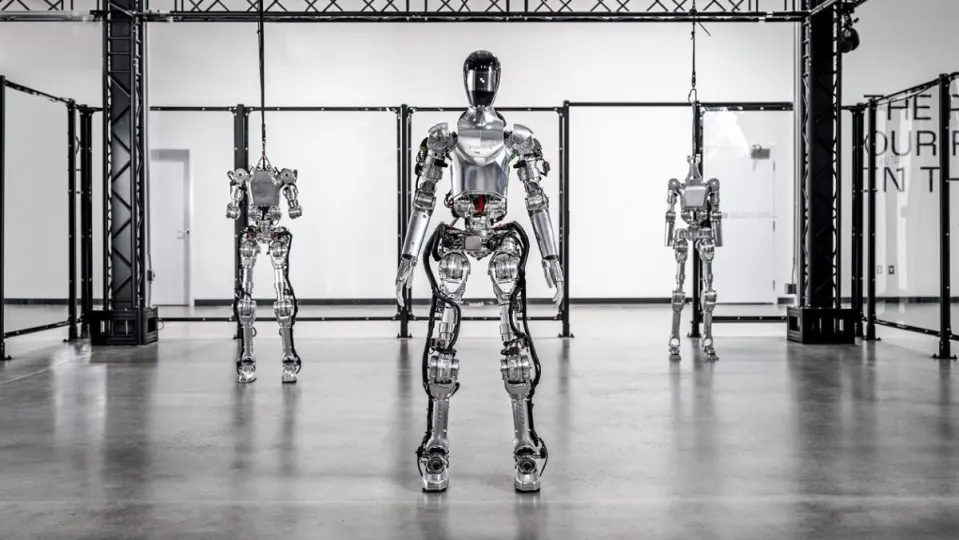

Durante décadas, el desarrollo de robots humanoides ha ido tan lento que parecía un imposible. Ahora se está acelerando rápidamente gracias a la colaboración entre Figure AI y OpenAI, y el resultado es el vídeo de robots humanoides más impresionante que hemos visto nunca.

El miércoles, la empresa de robótica Figure AI publicó un vídeo de actualización de su robot Figure 01 ejecutando un nuevo modelo de lenguaje visual (VLM). Esto ha hecho que el robot pase de ser un pelele a un robot de ciencia ficción que se acerca a las capacidades de C-3PO. Los robots de Tesla llamados Optimus tienen un serio rival.

Un vídeo que puede pasar a la historia

En el vídeo, el robot Figura 01 está de pie detrás de una mesa con un plato, una manzana y una taza. A la izquierda hay un escurridor. Una persona se sitúa frente al robot y le pregunta: “Figura 01, ¿qué ves ahora mismo?”.

Al cabo de unos segundos, la Figura 01 responde con una voz que suena extraordinariamente humana detallando todo lo que hay en la mesa y los pormenores del hombre que está de pie ante ella.

Entonces el hombre pregunta: “Oye, ¿puedo comer algo?”. La figura 01 responde: “Claro” y, con un movimiento fluido y diestro, coge la manzana y se la da al hombre.

A continuación, el hombre vacía unos papeles arrugados de un cubo delante de la figura 01 mientras pregunta: “¿Puedes explicar por qué has hecho lo que acabas de hacer mientras recoges esta basura?”.

La Figura 01 no pierde tiempo en explicar su razonamiento mientras vuelve a depositar el papel en el cubo. “Te he dado la manzana porque es lo único comestible que podía darte de la mesa”.

La empresa explica en un comunicado que Figure 01 realiza razonamientos “de voz a voz” utilizando el modelo multimodal preentrenado de OpenAI, VLM, para comprender imágenes y textos, y se basa en una conversación de voz completa para elaborar sus respuestas.

Esto es diferente de, por ejemplo, el GPT-4 de OpenAI, que se centra en indicaciones escritas.

También utiliza lo que la empresa llama “manipulación bimanual aprendida de bajo nivel”. El sistema combina calibraciones de imagen precisas (hasta un nivel de píxel) con su red neuronal para controlar el movimiento.

La empresa afirma que todos los comportamientos del vídeo se basan en el aprendizaje del sistema y no están teleoperados, lo que significa que no hay nadie entre bastidores manejando a la Figura 01.

Pero sin ver Figura 01 en persona y sin hacer nosotros las preguntas, es difícil verificar estas afirmaciones. Existe la posibilidad de que no sea la primera vez que el muñeco 01 realiza esta rutina. Podría haber sido la centésima vez, lo que podría explicar su velocidad y fluidez.