El enorme avance que está viviendo el mundo de las inteligencias artificiales tiene dos caras. Por un lado, la “revolución IA” puede ser de gran utilidad para los seres humanos, incluyendo labores tan sencillas como ayudarte con tus trabajos (ChatGPT) o crear imágenes en cuestión de segundos (Midjourney). Por otro lado, este desarrollo podría comprometer nuestra privacidad dependiendo de su implementación, algo que la Unión Europea pretende regular.

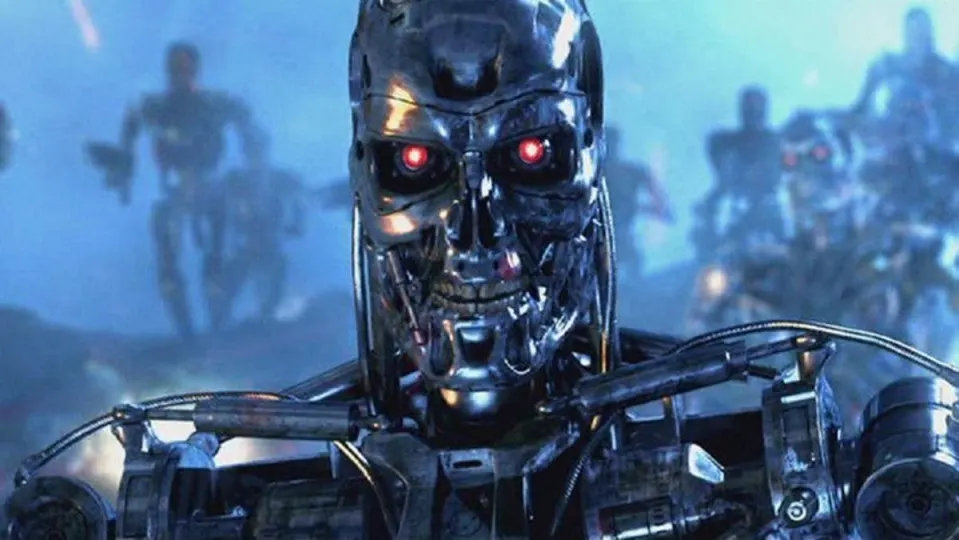

Pero, aun siendo un aspecto muy negativo e incluso distópico, la pérdida de la privacidad y otros riesgos asociados al avance de las inteligencias artificiales no serían, ni de lejos, lo peor que nos podría ocurrir como especie. La implementación a gran escala de las IA en nuestra sociedad conllevaría un enorme riesgo: la extinción total.

Y no, no es algo “fantasioso” y exclusivo de la ciencia ficción. Un grupo de líderes de la industria tecnológica, entre los que se encuentran grandes nombres, como Sam Altman (director ejecutivo de OpenAI), Demis Hassabis (director ejecutivo de Google DeepMind) y Dario Amodei (director ejecutivo de Anthropic) han advertido que las IA que están desarrollando podrían suponer algún día una amenaza para la propia existencia de la raza humana, y que estas deberían considerarse un riesgo social al mismo nivel que las guerras nucleares o las pandemias.

“Mitigar el riesgo de extinción de las inteligencias artificiales debería ser una prioridad mundial junto a otros riesgos a escala social, como las pandemias y la guerra nuclear”, reza una carta abierta firmada por los mayores líderes de la industria tecnológica que ha sido publicada por el Centro para la Seguridad de la IA, una organización sin ánimo de lucro.

“Existe la idea errónea, incluso en la comunidad de la inteligencia artificial, de que sólo hay un puñado de catastrofistas”, afirma Dan Hendrycks, director ejecutivo del Centro para la Seguridad de la IA. “Pero, de hecho, muchas personas expresan en privado su preocupación por estas cosas”.

La carta está firmada por más de 350 ejecutivos, investigadores e ingenieros que trabajan en el campo de la inteligencia artificial, y pone de relieve el peligro potencial de esta tecnología si no se establecen medidas tecnológicas y legislativas a tiempo.

La propia Microsoft respaldó la semana pasada una serie de normativas sobre IA que podría establecer el Gobierno de los Estados Unidos. Entre ellas, está la posibilidad de que las inteligencias artificiales puedan ralentizarse o desactivarse por completo en caso de emergencia.

Algunos de los enlaces añadidos en el artículo forman parte de campañas de afiliación y pueden representar beneficios para Softonic.