Las IA han llegado para quedarse. Desde los famosos chatbots con los que puedes mantener conversaciones, como el popular ChatGPT, su reciente integración en Bing y Bard, la nueva IA de Google; hasta las IA que generan imágenes, como DALL-E 2, Midjourney o Dream, y pasando por otras que nos ayudan en otros aspectos de nuestras vidas, como a la hora de cocinar, ya son muchas las posibilidades de la IA, y su avance es cada vez más prometedor, aunque también conlleva riesgos.

Uno de los miedos más recurrentes en el mundo de las IA es la posibilidad de que estas puedan ser “pirateadas”, como un programa normal y corriente. Zdnet ha indagado sobre este tema y ha entrevistado a varios profesionales que muestran su punto de vista sobre qué nos podría deparar la IA en un futuro, incluyendo sus riesgos potenciales, así como la forma de prevenir los posibles problemas.

En este aspecto, Bruce Draper, el director de programas de la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA), el organismo de investigación y desarrollo del Departamento de Defensa estadounidense, es una de las personas más cualificadas para entender bien todas las amenazas a las que nos podríamos ver sometidos si los malhechores tuvieran acceso a las IA que nos rodean.

“Los beneficios son reales, pero tenemos que hacerlo con los ojos abiertos: hay riesgos y tenemos que defender nuestros sistemas de IA”, dice Draper. “A medida que la inteligencia artificial se generaliza, se utiliza en todo tipo de sectores y entornos, y todos ellos se convierten en posibles superficies de ataque. Así que queremos dar a todos la oportunidad de defenderse”.

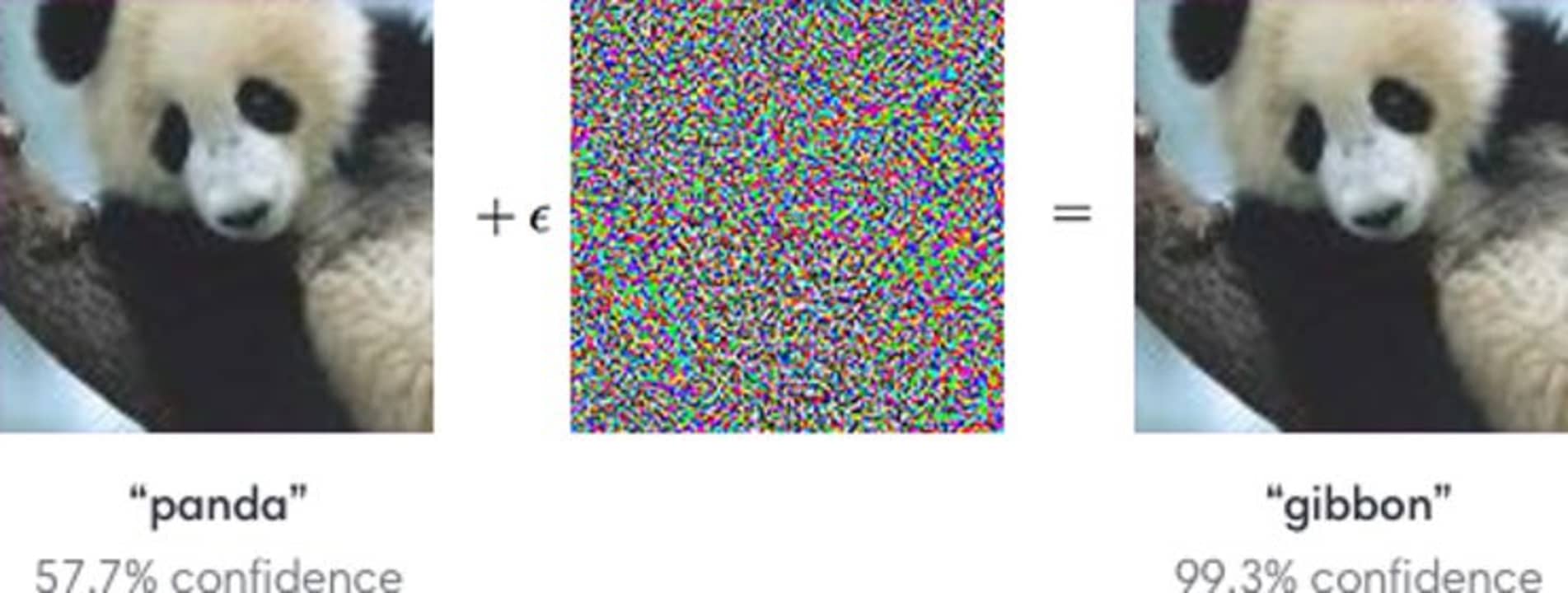

Mediante una táctica conocida como “ataque adversario”, un usuario que supiera bien lo que hace podría llegar a engañar a una IA introduciendo un pequeño cambio como input para que luego, tras realizar varios razonamientos lógicos “contaminados”, se provocase un gran cambio como output. De esta forma, podríamos llegar a hacer creer a una IA que la imagen de un gato es realmente un perro, aunque este tipo de manipulaciones podrían tener una gravedad mayor cuando pensamos en aspectos más serios, como la seguridad.

Ante esto, programas como GARD (Guaranteeing AI Robustness Against Deception), de DARPA, pretenden desarrollar herramientas que puedan proteger a las IA de ataques, así como evaluar la defensa de estas ante cualquier intento de manipulación o hackeo.

GARD se sirve de diferentes tipos de recursos para evaluar la solidez de los modelos de IA y sus defensas frente a ataques adversos, tanto los actuales como los futuros. Entre los componentes clave del proyecto, nos encontramos con Armory, una plataforma virtual de Github que sirve como banco de pruebas, y Adversarial Robustness Toolbox (ART), un conjunto de herramientas que también se hallan en Github y con las que los desarrolladores pueden defender a sus IA de este tipo de amenazas.

El avance de este tipo de tecnologías de defensa y prevención es de vital importancia, ya que, en un mundo donde las IA están y estarán aún más presentes en nuestro día a día, incluyendo nuestras casas, nuestros coches e incluso los establecimientos que visitamos, cualquier ataque podría dar lugar a que una ciudad entera se paralizara o que nuestros datos más íntimos, incluyendo los bancarios, estén al servicio de malhechores.